Saverio Lovergine – INAPP, Università di Tor Vergata – Rappresentante Stato Italiano c/o gruppo di lavoro ESCO in Commissione Europea (lovergine.saverio@gmail.com)

Brevi note sull’Intelligenza Artificiale

Occupandomi nel mio lavoro anche dell’impatto di AI, robotica e nuove tecnologie digitali su società, politica, economia e cultura – in particolare su lavoro, lavori e competenze – e verificando quanto tali tecnologie sono pervasive nella vita quotidiana, non credo assolutamente in una prospettiva/deriva essenzialmente tecnologica – imperativo tecnologico – ma sono a favore di un atteggiamento antideterministico rispetto alle trasformazioni tecnologiche. Infatti, ci deve essere sempre un controllo umano (AI “antropocentrica”), in quanto l’obiettivo è migliorare l’agire umano e i suoi diritti per costruire un atteggiamento di fiducia nell’AI (AI “affidabile”). Inoltre, viste le trasformazioni in atto, è importante definire un nuovo modello di governance per governare l’AI, un quadro istituzionale e regolativo che ne prospetta e definisce gli usi legittimi, e nel quale si inquadrano l’agire umano e i diritti dei cittadini.

Nello specifico condivido lo spirito e i contenuti dei sette principi fondamentali delle suddette linee guida UE:

- Azione e sorveglianza umane: in quanto i sistemi di AI “dovrebbero promuovere lo sviluppo di società eque sostenendo l’azione umana e i diritti fondamentali e non dovrebbero ridurre, limitare o sviare l’autonomia dell’uomo”.

- Robustezza e sicurezza: per una AI “di cui ci si possa fidare è indispensabile che gli algoritmi siano sicuri, affidabili e sufficientemente robusti da far fronte a errori o incongruenze durante tutte le fasi del ciclo di vita dei sistemi di Intelligenza artificiale”.

- Riservatezza e governance dei dati: per i quali i cittadini “dovrebbero avere il pieno controllo dei propri dati personali e nel contempo i dati che li riguardano non dovranno essere utilizzati per danneggiarli o discriminarli”.

- Trasparenza:pergarantire la tracciabilità dei sistemi di AI.

- Diversità, non discriminazione ed equità: perché i sistemi di AI dovrebbero considerare “l’intera gamma delle capacità, delle competenze e dei bisogni umani ed essere accessibili”.

- Benessere sociale e ambientale: perché i sistemi di AI dovrebbero promuovere i “cambiamenti sociali positivi e accrescere la sostenibilità e la responsabilità ecologica”.

- Accountability: i sistemi AI dovrebbero prevedere meccanismi “che garantiscano la responsabilità e il controllo dei sistemi e dei loro risultati”.

GOVERNANCE

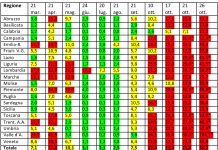

Aspetti positivi

L’enorme potenziale dell’AI di incidere su società, economia e cultura impone anche un ripensamento, se non una trasformazione, delle regole sociali, economiche, istituzionali e normative. Il primo aspetto positivo che porto alla Vs. attenzione è l’importanza della definizione di un nuovo modello di governance, ossia quali meccanismi e processi modelleranno e governeranno un’AI responsabile al fine di massimizzarne i benefici e minimizzare i rischi per la società e i cittadini. Una governance efficace è caratterizzata da una varietà di strumenti e soluzioni che influenzano lo sviluppo e le applicazioni dell’AI, al fine di: promuovere norme, etica e quadri dei valori;ricercare gli effetti, le implicazioni e le possibili soluzioni per l’uso dell’AI; attuare misure legislative e istituire organismi di regolamentazione formali per governare le tecnologie e i campi relativi all’AI. Su questo tema è stato incoraggiante vedere la politica, che in genere è in ritardo rispetto alle innovazioni tecnologiche, affrontare alcune preoccupazioni contemporanee poste dall’AI. Come nel caso dei 19 paesi che hanno concentrato i loro sforzi per affrontare le sfide etiche dell’AI attraverso la definizione di strategie nazionali[1][2]. Una regolamentazioneè necessaria per garantire un’efficace governance dell’AI. Ad esempio, i meccanismi legali possono ridurre i rischi pubblici dell’AI senza soffocare l’innovazione e far perdere la competitività di ogni stato a livello internazionale. Uno degli esempi è il Regolamento generale sulla protezione dei dati (GDPR), che anche se non menziona esplicitamente l’IA, tocca alcuni elementi importanti relativi a esso, come il ruolo dei dati e il processo decisionale autonomo (es. art. 22 del GDPR implica un diritto alla spiegazione del processo decisionale automatizzato, compresa la profilazione).

Aspetti problematici

La definizione di una nuova governance indotta dall’avvento dell’AI è ancora uno spazio in continua crescita. Il rovescio della medaglia è caratterizzato da tutti quegli aspetti – problematici – che ancora non sono stati definiti e governati in questa fase di sviluppo. L’AI e la trasformazione digitale devono essere inclusive e generare benefici per tutti i cittadini, comprese le categorie vulnerabili. Quindi, tutti gli specifici meccanismi e standard di governance dell’AI devono essere affrontati, quali ad esempio: etica e quadri di valori, norme e misure legislative, strumenti di regolazione e trasparenza dei sistemi autonomi e della distorsione algoritmica, sicurezza generale, AI digital divide, sistemi di armi autonome, etc. Al tempo della globalizzazione, tali aspetti devono essere affrontati non solo a livello locale e nazionale, ma anche a livello internazionale (globale), e devono coinvolgere tutti gli attori interessati: mondo accademico, le imprese, i governi, le organizzazioni internazionali, sovranazionali e nazionali, i cittadini.

LAVORO, LAVORI e COMPETENZE

La difficoltà di affrontare tali temi può essere riassunta raffrontando i dati sulle previsione a cinque anni dell’occupazione con l’avvento di AI, robotica e nuove tecnologie digitali, discussi nel World Economic Forum del 2016 (creazione di 2 milioni di posti di lavoro, a fronte di 7 che ne spariranno, con un saldo netto negativo di oltre 5 milioni di posti di lavoro) e del 2018 (la quarta rivoluzione industriale distruggerà 75 milioni di posti di lavoro nel mondo, ma ne creerà ben 133 milioni, con un saldo di 58 milioni (ma solo se si investirà nelle e-skills)).

Aspetti positivi

Il timore che le nuove tecnologie possano distruggere il lavoro è vecchio quanto quello verso il capitalismo, ma fin dai tempi delle proteste dei luddisti, tale preoccupazione è stata sempre smentita dalla storia economica che ci ha insegnato che le rivoluzioni industriali del passato hanno aumentato la ricchezza degli Stati e il benessere dei cittadini. Inoltre, per ogni posto di lavoro cancellato l’innovazione e le nuove tecnologie ne hanno sempre creati di nuovi, spesso più dignitosi e con un salario migliore. L’AI cambieràprofondamente il modo di lavorare. Fenomeni come lo smart workinge modelli flessibili e dinamici di organizzazione del lavoro, nel futuro troveranno ancora più spazio e diffusione, grazie ai profondi mutamenti nei modelli di business delle imprese (Industria 4.0, gig economy, e ICT in generale). Inoltre, nuovi lavori si affacciano e si affacceranno nel mercato del lavoro, di conseguenza c’è e ci sarà la richiesta di nuove competenze.Ai lavori creati si possono aggiungere anche quelli “riportati”, o “ricreati” (reshoring) nelle economie occidentali dalle imprese, che grazie all’AI e alle nuove tecnologie, stanno ripensando i propri modelli produttivi e riconsiderando le loro scelte di localizzazione, riportando nei paesi di “origine”, tutte o parte, le attività produttive precedentemente spostate in paesi emergenti. Comunque, anche se il progresso tecnologico negli ultimi anni ha subito un’accelerazione, rimane un processo lento a causa di ostacoli di natura economica, sociale e regolamentare. Pertanto, la sostituzione uomo-macchina non è detto che avvenga nei tempi e nei modi ipotizzati. Inoltre, molte professioni essendo composte da mansioni automatizzabili e non automatizzabili non permetterebbero la sostituzione totale di quel lavoratore.

Aspetti problematici

Negli ultimi tempi, numerose analisi di rilievo accademico, ma anche di tipo divulgativo e giornalistico, hanno proposto titoli che presagivano una serie di conseguenze negative per l’occupazione dovuta all’uso diffuso di AI, robotica e nuove tecnologie digitali. L’impatto di tali tecnologie sul mercato del lavoro è significativo in termini di mansioni (tasks) da svolgere e competenze (skills) richieste. In particolare, la tecnologica determina una crescente obsolescenza delle competenze, esacerbando il mismatch tra mansioni e competenze. Ad un modello “Skill Bias Technical Change” – ossia la tendenza a favorire, sia in termini occupazionali che in termini salariali, i lavoratori che hanno maggiori competenze legate alle tecnologie che governano i processi produttivi – si sta affiancando un modello “Routine Bias Technical Change”, che sposta l’attenzione dalla generica dotazione di skill dei lavoratori alle mansioni effettivamente svolte nei luoghi di lavoro, che sono il vero oggetto della potenziale (totale o parziale) sostituzione da parte delle macchine. Pertanto, ad una distinzione tra manodopera qualificata e non qualificata, si aggiunge una distinzione tra lavori manuali e processi cognitivi, di routine e non routine. Un’ipotesi che si fonda sull’idea che mentre le nuove tecnologie possono sostituire con relativa facilità i lavoratori impegnati in mansioni di tipo routinario, esse non sono in grado di sostituire il lavoro ad alta intensità di mansioni non routinarie, ove il ruolo della tecnologia è prevalentemente di tipo complementare, con la conseguenza che le macchine potrebbero sostituire alcuni compiti ad alto impiego non solo di tipo manuale, ma anche di impegno cognitivo. Il lavoro si sposta oramai sul digitale – comprensibile e misurabile per le macchine – e le macchine possono imparare il lavoro – le macchine possono fare il lavoro. Il rischio è enorme, tantissime persone potrebbero iniziare studi, che una volta conclusi, non garantirebbe loro il lavoro (o meno di quanto garantito ora). Non solo, i progressi di AI, robot e nuove tecnologie sono talmente rapidi e inarrestabili che le singole persone, le organizzazioni, i lavoratori e le loro competenze, e la politica stessa faticano a stare al passo di tali evoluzioni.

ALTRE PROBLEMATICHE

- L’organizzazione aziendale subirà notevoli cambiamentiche toccheranno le dimensioni spazio-temporali e dell’assoggettamento di tipo eterodirezionale. Per questo sarà necessario un nuovo modello di mercato del lavoro che permetterà a ogni lavoratore di non restare schiacciato da tale dimensione, che “imporrà” il buon funzionamento della rete nazionale dei servizi al lavoro, con una forte governance a livello locale e nazionale, se non transnazionale (es. Unione europea).

- Mai come oggi è importante l’investimento in capitale umano,istruzione e formazione. Il lavoratore “mediano” ha difficoltà a tenere il passo con le tecnologie più avanzate. Le nuove tecnologie e la robotica renderanno obsolescenti molti compiti e tecniche applicate imponendo ai lavoratori un ritmo molto più rapido e intaccando la professionalità dei lavoratori e rendendo indispensabili servizi efficaci di formazione e riqualificazione permanente. In questa direzione si renderanno necessari nuovi fabbisogni di competenze, facendo riferimento in particolare a quelle di tipo specialistico e a quelle trasversali (soft skills: leadership, formazione del team, creatività, etc.). Ciò imporrà un ripensamento (se non uno stravolgimento) dell’intero sistema educativo e formativo, nonché di una ri-alfabetizzazione degli adulti, “pressati” dal divario che si creerà tra velocità di cambiamento e velocità di apprendimento,per renderli sempre più “compatibili” con tale progresso tecnologico. Ancora più fondamentale sarà il rapporto tra sistema educativo e mondo aziendale, in un’ottica di capacità di anticipare i cambiamenti creati dalle nuove tecnologie. Importante sarà anche il ruolo degli uffici di placement negli istituti scolastici e nelle università, nonché di tutti gli altri strumenti di dialogo con i territori e le loro economie.

- In questo panorama, sta accadendo che pur, in presenza di crescita generale, un numero significativo di persone si veda diminuire il tenore di vita, creando una situazione in cui sono minacciati il contratto sociale, se non l’intero tessuto sociale in generale. Quindi si rende indispensabile l’ipotesi di una proposta politica di ridistribuzione del reddito, indipendentemente dalla forma proposta e attuata. Ciò al fine di favorire l’attività di re-skilling o forme di neo-imprenditorialità, dall’altro può non favorire il re-ingresso di disoccupati nel mondo del lavoro. Il tema del progresso tecnologico è un argomento che deve essere affrontato, in caso contrario i costi della transizione tra vecchi e nuovi posti di lavoro lo pagheranno i lavoratori più fragili, visto che la normativa e molti degli strumenti attualmente in uso non sono adeguati ad affrontare tale cambiamento, con il rischio che accanto a nuove opportunità di crescita si creino anche nuove diseguaglianze e discriminazioni.

- Il mercato del lavoro, se non il concetto di lavoro, non sarà più quello che intendiamo oggi. In futuro ci sarà un cambio di paradigma che modificherà, se non cambierà totalmente, le forme di protezioni del lavoro “tradizionali”. Le tipologie contrattuali si modificheranno, e sempre più spesso il lavoro a tempo indeterminato sarà sostituito da forme a tempo determinato o da forme più flessibili, mettendo in discussione anche le politiche previdenziali e le tecniche protettive tradizionali, nonché gli orari, i tempi e i modi di lavoro. I vecchi modelli di politiche del lavoro che si muovevano in un mercato dinamico, saranno investiti da AI, nuove tecnologie e dalla robotica che aumenteranno a livelli esponenziali tale dinamicità, creando situazioni nelle quali le proprie capacità negoziali delle persone saranno messe alla prova dai continui passaggi di rapporti di lavoro e di datori di lavoro, con il relativo rischio di non riuscire a muoversi al ritmo che il mercato imporrà loro, rimanendo schiacciati dal punto di vista sia reddituale che psico-sociale dovuto ai continui cambiamenti che in molti casi saranno imposti.

- Di fronte alla profondità e vastità dell’accelerazione tecnologica legata all’AI bisogna porsi il tema pressante di etica nella tecnologia. Si tratta di analizzare tutto il processo: ricerca, progettazione, produzione, distribuzione, utilizzo individuale e collettivo. Occorre individuare – se è possibile – un modello di monitoraggio interdisciplinare per la ricerca condivisa di un’etica dell’AI. “Il rischio è che con lo sviluppo di AI l’accesso e l’elaborazione diventino selettivamente riservate alle grandi holding economiche, ai sistemi di pubblica sicurezza, agli attori della governance politica. In altri termini, è in gioco l’equità nella ricerca di informazioni o nel mantenere i contatti con gli altri, se la sofisticazione dei servizi sarà automaticamente sottratta a chi non appartiene a gruppi privilegiati o non dispone di particolari competenze”.

Tre articoli o libri

- DAFOE A., AI governance: A research agenda, Governance of AI program, Future of Umanity Institute, University of Oxford, 2017;

- PARSON E., RE R., SOLOW-NIEDERMAN A., and ZEIDE E., Artificial Intelligence in strategic contest: an introduction, Program on Understanding Law, Science, and Evidence, UCLA School of Law, 2019.

- KAPLAN J., Le persone non servono. Lavoro e ricchezza nell’epoca dell’Intelligenza artificiale, Luiss University Press, 2016.

- KAPLAN J., Intelligenza artificiale. Guida al prossimo futuro, Luiss University Press, 2017.

Inoltre, tra gli esempi di strumenti e soluzioni che influenzano lo sviluppo e le applicazioni dell’AI cito, tra le aziende private, quello proposto dall’IBM. Una governance efficace caratterizzata da una varietà di strumenti, soluzioni e leve che influenzano lo sviluppo e le applicazioni dell’AI Tra le aziende private cito l’IBM che ha lanciato uno strumento per analizzare come e perché gli algoritmi prendono decisioni in tempo reale[3]. Anche Google ha lanciato nel 2017 Google DeepMind per aiutare i tecnologi a mettere in pratica l’etica e per aiutare la società ad anticipare e dirigere l’impatto dell’AI[4]. La Commissione europea nel 2018 ha pubblicato una comunicazione che delinea l’approccio europeo all’IA[5]; e il proprio Gruppo di esperti sull’AI ha pubblicato delle linee guida sull’etica dell’intelligenza artificiale[6].Nel Piano coordinato europeo tutti gli Stati membri sono stati invitati a sviluppare le loro strategie nazionali per l’IA, delineando i livelli di investimento e le misure di attuazione. L’Italia ha provveduto in tal senso elaborando la Strategia italiana per l’intelligenza artificiale[7]. Tra le organizzazioni non governativesi evidenzial’Institute for Electrical and Electronics Engineers (IEEE), che ha una vasta affiliazione globale di oltre 417.000 membri in oltre 160 paesi, che ha istituito una Iniziativa globale sull’etica degli autonomi e Sistemi intelligenti nel 2016[8]. Tra gli Istituti di ricerca invece si elencano: il Center for the Study of Existential Risks[9], Future of Humanity Institute[10], Future of Life Institute[11], Future Society[12], il Leverhulme Center for the Future of Intelligence[13], l’IA Now Institute[14], il Center for a New American Security[15], il MIT Media Lab e il Berkman Klein Center di Harvard[16], il Machine Intelligence Research Institute[17].

Anche l’ONUlavora sul potenziale e sulle conseguenze indesiderate delle tecnologie digitali, come l’IA[18], e pubblicato la propria strategia interna sulle nuove tecnologie[19]. Tra le sue organizzazioni che lavorano su tale tema ci sono: l’Istituto di ricerca sulla criminalità e la giustizia interregionale delle Nazioni Unite (UNICRI)[20], che ha aperto nel 2017 un Centro per l’Intelligenza Artificiale e la Robotica a L’Aia (Paesi Bassi)[21]. L’International Telecommunication Union (ITU) che organizza un vertice globale in collaborazione con agenzie affiliate delle Nazioni Unite, XPRIZE Foundation e ACM[22], ha una repository AI per identificare progetti, iniziative di ricerca, gruppi di riflessione e organizzazioni relativi all’IA che possono accelerare i progressi verso gli SDG[23], ed ha anche compilato un documento sulle attività generali delle Nazioni Unite in AI[24]. Anche il Centro universitario delle Nazioni Unite per la ricerca politica ha un programma sull’IA e sulla governance globale[25]. Il centro ha creato una piattaforma per coloro che si occupano di ricerca, governo, politica e industria per esplorare le sfide politiche globali sollevate dall’IA. L’Ufficio delle Nazioni Unite per il disarmo sostiene il lavoro del gruppo di esperti governativi sulle tecnologie emergenti nel settore dei sistemi letali di armi autonome[26].

[1]Miles Brundage et al., ‘The Malicious Use of Artificial Intelligence: Forecasting, Prevention, and Mitigation’, University of Oxford and others, 2018, https://arxiv.org/ftp/arxiv/papers/1802/1802.07228.pdf.

[2]Thomas A Campbell, ‘Artificial Intelligence: An Overview of State Initiatives’, FutureGrasp, 23 July 2019, https://www.researchgate.net/publication/334731776_ARTIFICIAL_INTELLIGENCE_AN_OVERVIEW_OF_STATE_INITIATIVES.

[3]Zoe Kleinman, ‘IBM Launches Tool Aimed at Detecting AI Bias’, BBC News, 19 September 2018, https://www.bbc.com/news/technology-45561955.

[4]Verity Harding and Sean Legassick, ‘Why We Launched DeepMind Ethics & Society’, DeepMind, 3 October 2017, https://deepmind.com/blog/announcements/why-we-launched-deepmind-ethics-society.

[5]European Commission, ‘Communication from the Commission to the European Parliament, the European Council, the Council, the European Economic and Social Committee and the Committee of the Regions: Artificial Intelligence for Europe’, COM (2018) 237 final, 25 April 2018, https://ec.europa.eu/transparency/regdoc/rep/1/2018/EN/COM-2018-237-F1-EN-MAIN-PART-1.PDF.

[6]European Commission’s High-Level Expert Group on Artificial Intelligence, ‘Draft Ethics Guidelines for Trustworthy AI’, 18 December 2018, https://ec.europa.eu/futurium/en/ai-alliance-consultation.

[7]https://www.mise.gov.it/images/stories/documenti/Strategia-Nazionale-Intelligenza-Artificiale-Bozza-Consultazione.pdf

[8]IEEE Standards Association, ‘IEEE Releases Ethically Aligned Design: A Vision for Prioritizing Human Wellbeing with Artificial Intelligence and Autonomous Systems for Public Discussion’, press release, 16 December 2016, https://standards.ieee.org/content/dam/ieee-standards/standards/web/documents/other/ead_v2.pdf.

[9]Centre for the Study of Existential Risk, <https://www.cser.ac.uk/>.

[10]Future of Humanity Institute, <https://www.fhi.ox.ac.uk/>.

[11]Future of Life Institute, ‘Asilomar AI Principles’, 2017, https://futureoflife.org/ai-principles/?cn-reloaded=1.

[12]Future Society, https://thefuturesociety.org/.

[13]Leverhulme Centre for the Future of Intelligence, <http://lcfi.ac.uk/>.

[14]AI Now Institute, <https://ainowinstitute.org/>.

[15]Center for a New American Security, <https://www.cnas.org/>.

[16]The Ethics and Governance of Artificial Intelligence Initiative, <https://aiethicsinitiative.org/>.

[17]Machine Intelligence Research Institute, <https://intelligence.org/>.

[18]UN, ‘Secretary-General’s High-Level Panel on Digital Cooperation’, 2018.

[19]UN, ‘Secretary-General’s Strategy on New Technologies’, 2018.

[20]UN Interregional Crime and Justice Research Institute (UNICRI), ‘Centre for Artificial Intelligence and Robotics’, 2018, <http://www.unicri.it/in_focus/on/UNICRI_Centre_Artificial_Robotics.

[21]UNICRI, ‘Centre on Artificial Intelligence and Robotics’, 2017.

[22]International Telecommunication Union (ITU), ‘AI for Good Global Summit’, 2017.

[23]ITU, ‘AI Repository’, 2018.

[24]ITU, ‘United Nations Activities on Artificial Intelligence’, 2018.

[25]UN University, ‘AI & Global Governance’, 2019.

[26]UN Office for Disarmament Affairs.

_____

Foto di Gerd Altmann da Pixabay